NVIDIA's Computex 2025-revolutie: Datacenters veranderen in AI-fabrieken

Jensen Huang, CEO van NVIDIA, betrad het podium van Computex 2025 in zijn kenmerkende leren jasje en onthulde nieuwe hardware en een volledig nieuw computerparadigma. De halfgeleidergigant heeft zich resoluut omgevormd tot een AI-infrastructuurbedrijf, dat de basis legt voor wat Huang "de infrastructuur van intelligentie" noemt - de derde grote infrastructuurrevolutie na elektriciteit en internet.

Deze keynote was niet zomaar een productaankondiging, het was Jensen die NVIDIA's blauwdruk voor een nieuwe vormgeving van het computerlandschap uit de doeken deed. De technische sprongen, strategische draaipunten en marktspelers die hij onthulde, zullen er waarschijnlijk voor zorgen dat dit de Computex wordt waar we nog jaren naar zullen verwijzen. Bekijk de volledige Computex 2025 Nvidia keynote.

NVIDIA's strategische evolutie: Van grafische kaarten tot infrastructuurleverancier

Het transformatieverhaal van NVIDIA is verbluffend. In 1993 zag Jensen een "chipkans van 300 miljoen dollar" - een substantiële markt. We gaan snel vooruit naar vandaag, en hij heeft de leiding over een biljoen dollar kostende moloch op het gebied van AI-infrastructuur. Dat soort explosieve groei gebeurt niet zomaar - NVIDIA heeft zichzelf onderweg meerdere keren fundamenteel opnieuw uitgevonden.

Tijdens zijn keynote benadrukte Jensen de keerpunten die het huidige NVIDIA mogelijk hebben gemaakt:

2006: CUDA landde en zette parallel computing op zijn kop. Plotseling bouwden ontwikkelaars die nooit hadden overwogen om GPU's te gebruiken voor algemene berekeningen, toepassingen die onmogelijk zouden zijn geweest op traditionele CPU's.

2016: De DGX1 werd NVIDIA's eerste op AI gerichte systeem zonder compromissen. In wat er nu uitziet als een bijna griezelige voorbode, schonk Jensen de eerste unit aan OpenAI, waarmee ze effectief de rekenkundige basis legden die uiteindelijk zou leiden tot onze huidige AI-revolutie.

2019: De overname van Mellanox, waardoor NVIDIA datacenters kan herconceptualiseren als Unified Computing Units.

Deze transformatie culmineert in NVIDIA's huidige positie als "een essentieel infrastructuurbedrijf" - een status die Huang benadrukte door te wijzen op de ongeëvenaarde vijfjarige openbare roadmaps, die wereldwijde infrastructuurplanning voor AI-implementatie mogelijk maken.

Het herdefiniëren van prestatiecijfers: De tokeneconomie

NVIDIA heeft een fundamentele verschuiving geïntroduceerd in de manier waarop we rekenkracht meten. In plaats van traditionele meetmethoden zoals FLOP's of bewerkingen per seconde, positioneerde Huang AI-datacenters als fabrieken die "tokens" produceren, eenheden van rekenkundige intelligentie:

"Bedrijven beginnen te praten over hoeveel tokens ze afgelopen kwartaal hebben geproduceerd en hoeveel tokens ze afgelopen maand hebben geproduceerd. Zeer binnenkort zullen we het hebben over hoeveel tokens we elk uur produceren, net zoals elke fabriek dat doet."

Deze herformulering legt een direct verband tussen computationele investeringen en bedrijfsoutput en brengt AI-infrastructuur op één lijn met traditionele industriële kaders. Het model positioneert NVIDIA in het epicentrum van een nieuw economisch paradigma waar computationele efficiëntie zich direct vertaalt naar zakelijke capaciteit.

Blackwell Architecture Upgrades: GB300 specificaties en prestatiecijfers

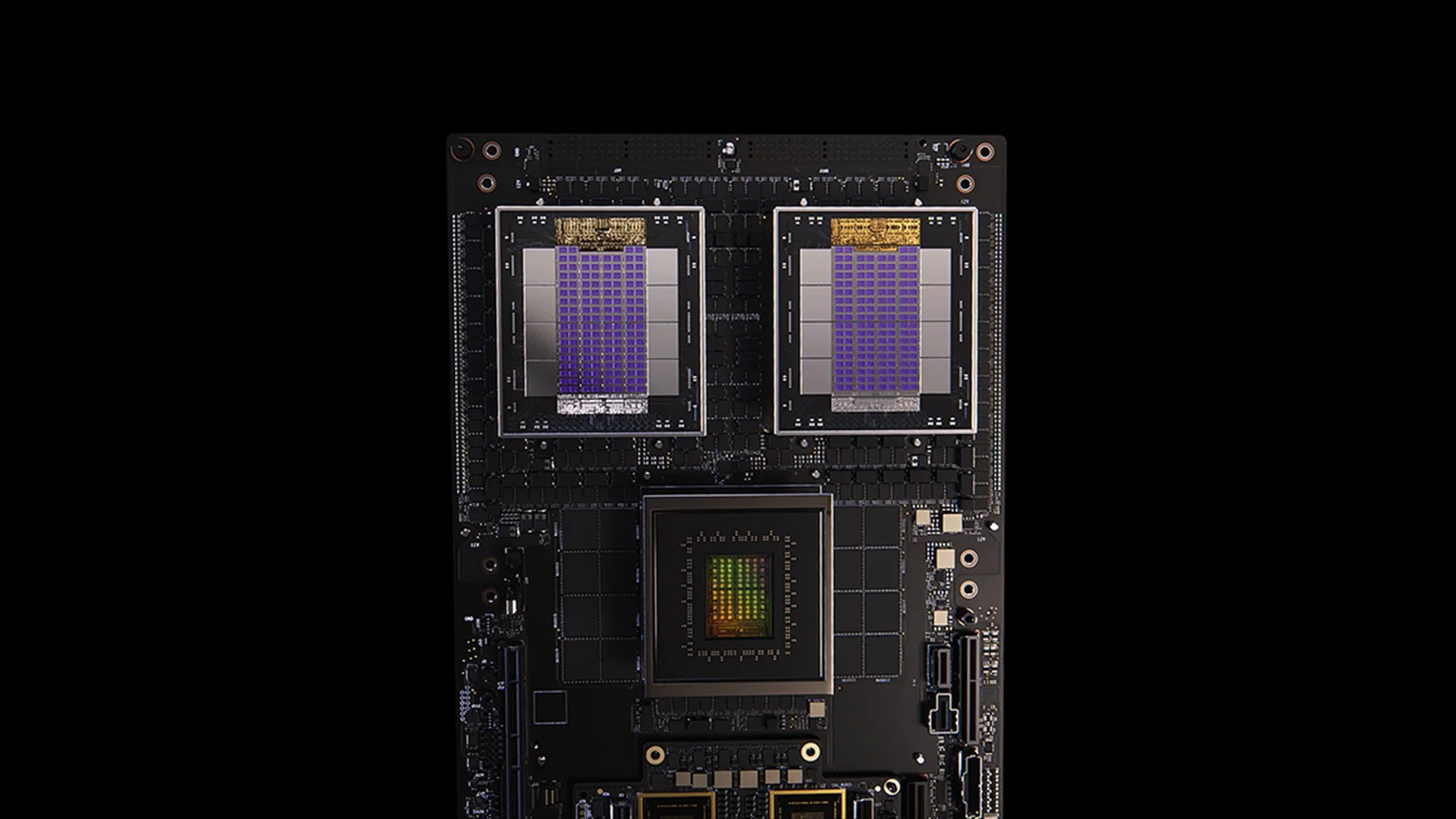

GB200 systeem

De GB300-update voor de Blackwell-architectuur is een voorbeeld van NVIDIA's niet-aflatende cyclus van prestatieverbetering. Gepland voor Q3 2025, de GB300 levert:

1,5x verbeterde inferentieprestaties ten opzichte van GB200

1,5x HBM-geheugencapaciteitstoename

2x verbeterde netwerkbandbreedte

Volledig vloeistofgekoeld ontwerp

Achterwaarts compatibel met bestaande chassis en systemen

Elke GB300-node levert ongeveer 40 petaflops, waarmee de hele Sierra-supercomputer (circa 2018), waarvoor 18.000 Volta GPU's nodig waren, wordt vervangen. Deze prestatiewinst van 4000x binnen zes jaar overtreft ruimschoots de traditionele Moore's Law-schaling en toont NVIDIA's veelzijdige benadering van prestatieversnelling door middel van architectuur-, software- en interconnectinnovaties.

MVLink: Een nieuwe definitie van interconnectietechnologie

MVLink vertegenwoordigt de belangrijkste vooruitgang in GPU interconnectietechnologie sinds de introductie van NVLink. Het systeem maakt volledige opsplitsing van computermiddelen over een heel rack mogelijk, waardoor 72 GPU's (144 GPU dies) één gigantische rekeneenheid worden.

De technische specificaties zijn verbluffend:

Afzonderlijke MVLink schakelaars: 7,2 TB/s bandbreedte

MVLink ruggengraat: 130 TB/s all-to-all bandbreedte

Fysieke implementatie: 5.000 nauwkeurig op lengte afgestemde coaxkabels (in totaal ongeveer 2 mijl)

Vermogensdichtheid: 120 kilowatt per rack (vloeistofkoeling noodzakelijk)

Ter context merkte Huang op dat het piekverkeer van het hele internet ongeveer 900 terabit per seconde (112,5 TB/s) bedraagt, waardoor een enkele MVLink ruggengraat meer verkeer kan verwerken dan het wereldwijde internet op piekcapaciteit.

MVLink Fusion: Een open AI-infrastructuurecosysteem creëren

MVLink Fusion is misschien wel het meest innovatieve ecosysteemspel dat NVIDIA in jaren heeft gemaakt. In plaats van partners te dwingen all-in te gaan op NVIDIA hardware, openen ze de architectuur om bedrijven semi-aangepaste AI systemen te laten bouwen die nog steeds aansluiten op het NVIDIA universum.

De aanpak is verrassend flexibel:

Aangepaste ASIC-integratie: Heb je een gespecialiseerde versneller? Geen probleem. Partners kunnen MVLink-chiplets laten vallen om hun aangepaste silicium aan te sluiten op het ecosysteem van NVIDIA. Het is alsof NVIDIA zegt: "Bouw wat voor gespecialiseerde hardware je maar wilt - zorg er alleen voor dat het met onze spullen kan praten."

Aangepaste CPU-integratie: CPU-leveranciers worden ook niet overgeslagen. Ze kunnen MVLink's chip-naar-chip interfaces direct implementeren, waardoor er een directe snelweg ontstaat tussen hun processoren en Blackwell GPU's (of de aankomende Ruben architectuur). MVLink is enorm belangrijk voor bedrijven die in specifieke CPU-architecturen hebben geïnvesteerd.

Partneraankondigingen bestrijken de hele halfgeleiderindustrie:

Silicium-implementatiepartners: LCHIP, Astera Labs, Marll, MediaTek

CPU-leveranciers: Fujitsu, Qualcomm

EDA-leveranciers: Cadence, Synopsis

Deze aanpak positioneert NVIDIA strategisch om waarde te creëren, ongeacht de specifieke hardwaremix die klanten inzetten, en weerspiegelt de openhartige uitspraak van Huang: "Niets geeft me meer vreugde dan wanneer je alles van NVIDIA koopt. Ik wil dat jullie dat weten. Maar het geeft me enorm veel plezier als je iets van NVIDIA koopt."

Enterprise AI-implementatie: RTX Pro Enterprise en Omniverse Server

De RTX Pro Enterprise en Omniverse server vertegenwoordigen NVIDIA's belangrijkste bedrijfsgerichte compute-aanbod, speciaal ontworpen om AI-mogelijkheden te integreren in traditionele IT-omgevingen:

Volledig x86-compatibele architectuur

Ondersteuning voor traditionele hypervisors (VMware, Red Hat, Nanix)

Kubernetes-integratie voor vertrouwde werklastorkestratie

Blackwell RTX Pro 6000s GPU's (8 per server)

CX8 netwerkchip met 800 Gb/s bandbreedte

1,7x prestatieverbetering ten opzichte van Hopper H100

4x prestaties op geoptimaliseerde modellen zoals Deepseek R1

Het systeem stelt een nieuwe prestatiegrens vast voor AI-inferentie, gemeten in een kader met twee assen: doorvoer (tokens per seconde) en responsiviteit (tokens per seconde per gebruiker) - cruciale meetgegevens voor wat Huang omschrijft als het tijdperk van "inferentietijdschaling" of "denkende AI".

AI Data Platform: Opnieuw vormgeven van opslag voor ongestructureerde data

NVIDIA's AI Data Platform introduceert een fundamenteel andere benadering van bedrijfsopslag:

"Mensen bevragen gestructureerde databases zoals SQL... Maar AI wil ongestructureerde gegevens bevragen. Ze willen semantiek. Ze willen betekenis. En dus moeten we een nieuw type opslagplatform creëren."

De belangrijkste onderdelen zijn:

NVIDIA AIQ (of IQ): Een semantische zoeklaag

GPU-versnelde opslagknooppunten die traditionele CPU-gerichte architecturen vervangen

Post-trained AI-modellen met transparante herkomst van trainingsgegevens

15x sneller query's uitvoeren met 50% betere resultaten vergeleken met bestaande oplossingen

Tot de storage-partners die deze architectuur implementeren behoren Dell, Hitachi, IBM, NetApp en Vast, waardoor een uitgebreid ecosysteem voor AI-datamanagement voor bedrijven ontstaat.

AI-operaties en robotica: Software frameworks voor de intelligente onderneming

De keynote introduceerde twee cruciale software frameworks:

AI-operaties (AIOps): Een uitgebreide stack voor het beheren van AI-agenten in bedrijfscontexten, inclusief datacuration, model fine-tuning, evaluatie, vangrails en beveiliging. Partners zijn onder andere Crowdstrike, Data IQ, Data Robots, Elastic, Newonix, Red Hat en Trend Micro.

Isaac Groot Platform N1.5: Een open ecosysteem voor robotica-ontwikkeling, inclusief:

Newton fysica-engine (ontwikkeld met Google DeepMind en Disney Research)

Jetson Thor robotica-processor

NVIDIA Isaac-besturingssysteem

Groot Dreams blauwdruk voor het genereren van synthetische baangegevens

Het robotica-initiatief pakt een kritieke uitdaging aan: "Om robotica te laten gebeuren, heb je AI nodig. Maar om de AI te leren, heb je AI nodig." Dit recursieve optimalisatiepatroon maakt gebruik van generatieve AI om beperkte menselijke demonstratiegegevens uit te breiden tot uitgebreide robotica-trainingssets.

De strategische positie van Taiwan in de AI-productierevolutie

Een aanzienlijk deel van de keynote benadrukte de centrale rol van Taiwan in zowel de productie als de implementatie van AI-technologieën:

Taiwanese productiebedrijven (TSMC, Foxconn, Wistron, Pegatron, Delta Electronics, Quanta, Wiiwin, Gigabyte) zetten NVIDIA Omniverse in voor digital twin-implementaties.

TSMC gebruikt AI-tools op CUDA om lay-outs van fabs en leidingsystemen te optimaliseren

Productiepartners gebruiken digitale tweelingen voor virtuele planning en voorspellend onderhoud en als "robot gymms" voor het trainen van robotsystemen.

Foxconn, TSMC, de Taiwanese overheid en NVIDIA bouwen de eerste grootschalige AI-supercomputer van Taiwan.

Huang bevestigde NVIDIA's betrokkenheid bij de regio door plannen aan te kondigen voor "NVIDIA Constellation", een nieuw hoofdkantoor in Taipei.

Technische analyse: Wat betekent dit voor de AI-strategie van ondernemingen?

Deze aankondigingen vormen samen een alomvattende herdefiniëring van enterprise computing met verschillende strategische implicaties:

Vereisten voor computerschaal: De inferentietijd-prestatievereisten van "redenerende AI" en agentgebaseerde systemen zullen aanzienlijk hogere rekenvereisten stellen dan de initiële grote taalmodelimplementaties, waardoor architecturale planning voor massale schaalvergroting en schaaluitbreiding nodig is.

Disaggregatie van ondernemings-AI: Het MVLink Fusion ecosysteem maakt ongekende flexibiliteit mogelijk bij het bouwen van heterogene AI-systemen, waardoor de toepassing van gespecialiseerde AI-versnellers mogelijk wordt versneld, terwijl NVIDIA's positie in het ecosysteem behouden blijft door middel van interconnectietechnologie.

Verschuiving van datacenters naar AI-fabrieken: We moeten volledig opnieuw nadenken over hoe we de waarde van onze infrastructuurinvesteringen meten. De dagen dat de ruwe reken- of opslagcapaciteit het hele verhaal vertelde, zijn voorbij. Nu draait alles om tokenproductie: hoeveel eenheden AI-output kunnen uw systemen genereren per seconde, per watt en per dollar? Jensen maakte geen grapje toen hij zei dat bedrijven binnenkort hun tokenproductie zouden rapporteren, zoals productiecijfers. De verschuiving naar AI-fabrieken zal de economische aspecten van hoe we AI-infrastructuur inzetten en rechtvaardigen fundamenteel herschrijven.

Integratie van digitale tweelingen: Het feit dat elke grote Taiwanese fabrikant digitale tweelingen van Omniverse bouwt, vertelt ons alles wat we moeten weten - dit is niet meer alleen een coole techdemo. Digitale tweelingen zijn essentiële infrastructuur geworden voor bedrijven die optimalisatie serieus nemen. Wat vooral fascinerend is, is hoe dit een feedback-loop creëert: bedrijven bouwen digital twins om fysieke processen te optimaliseren en gebruiken diezelfde omgevingen vervolgens om AI en robotica te trainen, waardoor de fysieke wereld verder wordt verbeterd. Het is een continue verbeteringscyclus die steeds sneller gaat.

Robotic Workforce Planning: De convergentie van agentische AI en fysieke robotica suggereert dat organisaties geïntegreerde digitale en fysieke automatiseringsstrategieën moeten ontwikkelen, met aanzienlijke gevolgen voor de personeelsplanning en het ontwerp van faciliteiten.

Softwaregedefinieerde infrastructuur: Ondanks de hardware-aankondigingen, versterkt NVIDIA's voortdurende nadruk op bibliotheken en softwareframeworks dat concurrentievoordeel in AI net zo goed zal komen van software-optimalisatie als van ruwe hardwaremogelijkheden.

Navigeren door de AI-fabrieksovergang

Het transformeren van traditionele datacenters in AI-fabrieken vereist gespecialiseerde expertise die een brug slaat tussen de inzet van hardware, softwareoptimalisatie en architectonisch ontwerp. Bij Introl implementeren we deze geavanceerde GPU-infrastructuuroplossingen voor bedrijven die de sprong wagen naar AI-first computing. De diepgaande ervaring van ons team met het ecosysteem van NVIDIA - van complexe MVLink-implementaties tot Omniverse digital twin-implementaties - helpt organisaties bij deze paradigmaverschuiving zonder de steile leercurve die meestal gepaard gaat met geavanceerde infrastructuur. Of het nu gaat om het opschalen van redenerende AI-mogelijkheden of het bouwen van uw eerste AI-fabrieksvloer, samenwerken met specialisten kan uw time-to-value in dit snel evoluerende landschap drastisch versnellen. Klaar om **het voor elkaar te krijgen? Maak vandaag nog een afspraak.

Conclusie: Het derde tijdperk van computers is aangebroken

Computex was niet alleen NVIDIA die snellere chips liet zien. Wat Jensen liet zien, ging verder dan de gebruikelijke "20% beter dan vorig jaar"-aankondigingen waar we aan gewend zijn geraakt. Hij herdefinieert fundamenteel waar computers voor dienen. We bouwen al tientallen jaren machines die getallen kraken en gegevens verplaatsen. Nu bouwt NVIDIA systemen die primair intelligentie produceren. Het is alsof je een archiefkast met hersenen vergelijkt. Natuurlijk, beide slaan informatie op, maar de ene zit daar terwijl de andere nieuwe ideeën creëert. De verschuiving klinkt misschien als semantiek, totdat je je realiseert dat het alles verandert aan de manier waarop we computersystemen bouwen, inzetten en meten.

"Voor het eerst in al onze tijd samen creëren we niet alleen de volgende generatie IT, maar hebben we dat ook meerdere keren gedaan, van pc naar internet naar cloud naar mobiele cloud. Dat hebben we verschillende keren gedaan. Maar deze keer creëren we niet alleen de volgende generatie IT, we creëren ook een hele nieuwe industrie."

Deze overgang vertegenwoordigt de derde grote verschuiving in het computerparadigma, na de revolutie van personal computing en het internet/cloud-tijdperk. Organisaties die deze AI-infrastructuurcapaciteiten integreren zullen waarschijnlijk onoverkomelijke concurrentievoordelen behalen in verschillende sectoren.

De fabrieken van computationele intelligentie zijn vandaag de dag in aanbouw. De vraag is niet langer of AI het bedrijfsleven zal transformeren, maar of uw organisatie de infrastructuur bouwt om concurrerend te blijven in een wereld waarin computationele intelligentie net zo fundamenteel wordt voor de bedrijfsvoering als elektriciteit.

Referenties en aanvullende bronnen

NVIDIA Officieel Blackwell-architectuuroverzicht: https://www.nvidia.com/en-us/data-center/technologies/blackwell-architecture/

NVIDIA MVLink Technische documentatie: https://developer.nvidia.com/mvlink

NVIDIA Omniverse Platform: https://www.nvidia.com/en-us/omniverse/

Isaac Robotica Platform: https://developer.nvidia.com/isaac-ros

NVIDIA AI Onderneming: https://www.nvidia.com/en-us/data-center/products/ai-enterprise/

NVIDIA Computex 2025 Officieel Persmateriaal: https://nvidianews.nvidia.com/news/computex-2025

Overzicht NVIDIA CUDA-X-bibliotheken: https://developer.nvidia.com/gpu-accelerated-libraries

NVIDIA DGX systemen: https://www.nvidia.com/en-us/data-center/dgx-systems/